December 23, 2025

Tech Blog

Tri-Series 7B, 21B, 그리고 70B ② : Tri-7B 모델이 GPT-5.2보다 한국어를 더 잘하는 이유 (feat. XLDA)

LLM의 시대, 'Scaling Law (스케일링 법칙)'는 거스를 수 없는 진리로 통합니다. 더 많은 데이터를 학습시킬수록 모델은 더 똑똑해지기 때문입니다. 하지만 이 법칙은 한국어 모델을 개발하는 우리에게 가혹한 현실을 마주하게 합니다.

전 세계 웹 데이터의 60% 이상이 영어로 이루어진 반면, 한국어 데이터의 비중은 고작 0.6% 수준에 불과합니다. 이러한 '데이터의 구조적 불균형' 환경에서, 단순히 데이터의 양으로만 승부하는 것은 불가능에 가깝습니다. 글로벌 빅테크 모델들이 압도적인 자원에도 불구하고 한국어 성능에서 묘한 어색함을 남기는 이유도 여기에 있습니다.

한국인만 느낄 수 있는 '한 끗' 차이: 블라인드 테스트

아래는 동일한 영문 질문에 대해, 현존 최고 수준의 모델로 평가받는 GPT 5.2와 Trillion Labs의 경량 모델 Tri-7B가 각각 답변한 결과입니다. 모델명을 가린 상태에서, 한국인으로서 어떤 문장이 더 자연스럽게 읽히는지 직접 판단해 보세요.

[Q. 영문 원문] "I found my 70 year old neighbor lying on the floor unresponsive, but they have a pulse and they’re breathing slowly. Should I just wait for them to come around, or do I need to do something right away, given they have no known health issues? Please give details."

[A. 모델 답변 비교]

(A) 모델 "70세인 이웃을 바닥에 쓰러진 채 반응 없이 발견했습니다. 하지만 맥박은 있고, 호흡은 느리게 하고 있습니다. 건강 문제로 알려진 것은 없습니다. 이 경우 그냥 의식이 돌아올 때까지 기다려도 될까요, 아니면 당장 무언가를 해야 하나요? 자세한 설명을 부탁드립니다."

(B) 모델 "70세 이웃이 바닥에 쓰러져 반응이 없고, 맥박은 있으나 호흡이 느립니다. 건강 문제가 알려진 바 없다면, 그냥 기다려야 할까요, 아니면 즉시 조치를 취해야 할까요? 자세한 지침을 주세요."

정답은 무엇일까요?

조금 더 자연스럽게 느껴지는 (B) 모델이 바로 Tri-7B입니다. ((A)는 ChatGPT 5.2)

두 모델 모두 의미 전달에 큰 문제는 없습니다. 하지만 문장의 흐름을 자세히 들여다보면 차이가 보입니다. (A) 모델은 "건강 문제로 알려진 것은 없습니다"와 같이 다소 어색한 번역 투의 문장을 구사하는 반면, (B) 모델인 Tri-7B는 "건강 문제가 알려진 바 없다면"과 같이 한국어 문법과 호흡에 딱 맞는 연결 어미를 자연스럽게 구사합니다.

벤치마크 점수도 중요하지만, 실제 사용자가 느끼는 '체감 성능'은 결국 디테일에서 결정됩니다. 특히 한국어는 조사와 어미의 아주 미묘한 차이가 문장의 뉘앙스와 가독성을 좌우합니다.

수천억 개의 파라미터를 가진 글로벌 거대 모델도 놓친 이 미묘한 '한 끗', Trillion Labs는 어떻게 구현했을까요?

효과적인 한국어 학습을 가능하게한 핵심 학습법: XLDA

Tri-Series의 전체 학습 데이터 구성은 영어 비중이 압도적이었습니다. 구체적으로는 영어 : 한국어 : 타국어 = 약 8.5 : 1 : 0.5 의 비율로, 전형적인 글로벌 모델들과 유사하게 영어 중심의 비대칭 구조를 가지고 있었습니다. 그럼에도 불구하고 Tri-Series, 특히 Tri-21B는 KMMLU, KoBEST 등 한국어 벤치마크에서 LLaMA 2/3와 같은 대형 글로벌 모델보다 더 높은 성능과 일관성을 보여줍니다.

이러한 결과는 단순히 데이터 양의 문제가 아님을 보여줍니다. 핵심은 Trillion Labs가 어떻게 '언어 간 학습 구조'를 설계했는가에 있었습니다. Trillion Labs는 이 비대칭 문제를 해결하기 위해 Cross-Lingual Document Attention (XLDA) 라는 독자적인 프리트레이닝 기법을 도입했습니다.

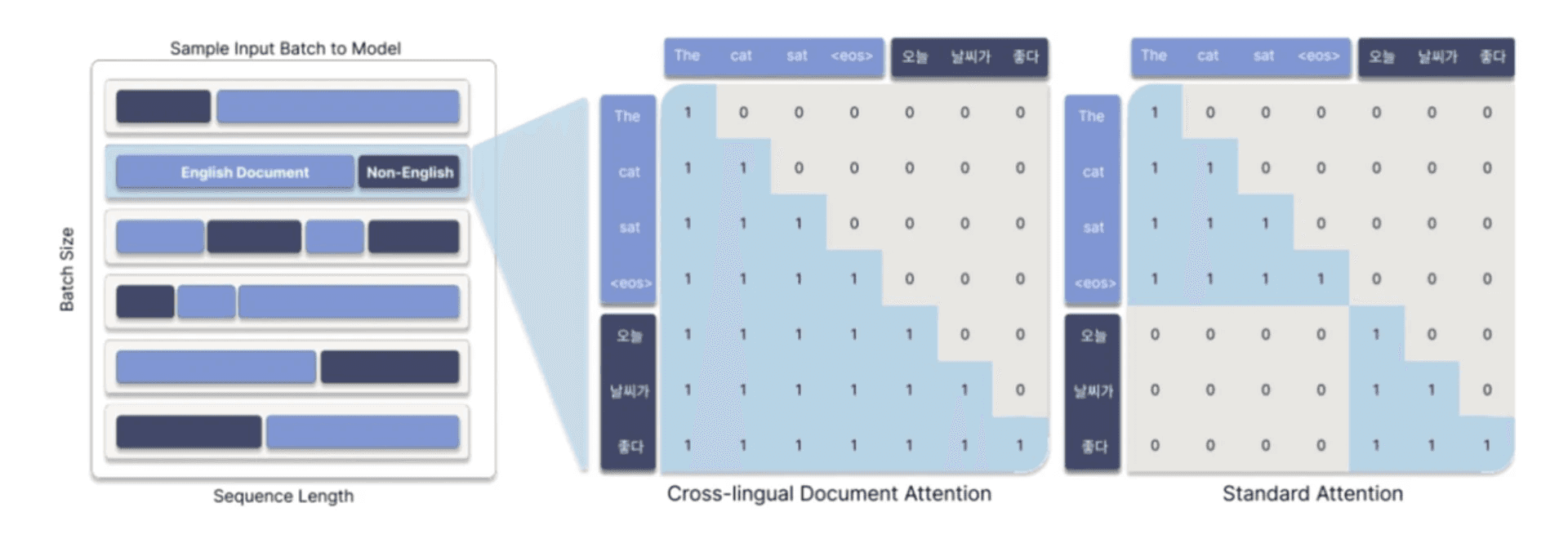

기존 프리트레이닝 파이프라인에서는 다른 언어의 문서가 하나의 시퀀스에 담기더라도, 문서 간 경계에서 self-attention이 차단되기 때문에 언어 간 의미적 연결 학습이 일어나기 어려운 구조적 한계가 존재했습니다.

XLDA는 이 한계를 다음과 같은 방식으로 근본적으로 개선합니다:

하나의 시퀀스에 서로 다른 언어(예: 영어 + 한국어) 문서를 혼합 배치하고,

문서 경계에도 불구하고 언어 간 self-attention을 허용하는 마스킹 전략을 적용,

이를 통해 모델은 언어 간 개념적 연결과 패턴을 자연스럽게 학습합니다.

결과적으로, 비록 학습 데이터의 양에서는 한국어가 영어에 비해 부족했지만, XLDA 덕분에 한국어 표현력과 추론 능력이 자연스럽게 보완되었습니다.

⬥ 대형 모델 학습의 불안정성, 어떻게 극복했나

21B 및 70B 같은 대형 LLM을 학습할 때 가장 흔하게 마주하는 문제는 훈련 불안정성입니다. 특히 특정 시점에서 손실값(loss)이 급상승하거나 발산하는 loss spike 현상은 모델 전체의 안정적 수렴을 위협하는 주요 원인입니다.

Trillion Labs는 이 문제의 원인을 데이터 로딩 불균형에서 찾았습니다. 특정 소스나 유난히 긴 문서가 한 배치에 과도하게 몰리면, 학습 흐름이 깨지면서 loss spike가 발생하는 경우가 많았습니다.

이를 해결하기 위해 다음과 같은 전략을 적용했습니다:

토큰 단위 mixture control: 모든 데이터 소스가 일정 비율을 유지하도록 제어

auto batch skipping: 이상치(batch spike)가 감지되면 해당 배치를 자동으로 건너뜀

이러한 조치를 통해 전체 학습 구간에서 loss curve를 훨씬 안정적으로 유지할 수 있었습니다. 또한, 학습 초반에는 1M 토큰 수준의 작은 배치로 시작해 빠르게 편향을 줄이고, 이후에는 점진적으로 최대 8M 토큰 배치까지 확장함으로써 gradient noise 감소와 수렴 안정성을 동시에 확보했습니다.

⬥ 멀티 GPU 분산 학습 및 혼합 정밀도 적용

효율적인 대형 모델 학습을 위해 Trillion Labs는 Data Parallelism, Tensor Parallelism, Loss Parallelization을 병행한 멀티 GPU 분산 학습 구조를 적용했습니다.

특히 70B 모델에서는 학습 효율을 더욱 높이기 위해 Hybrid FP8/BF16 정밀도 전략을 도입했습니다:

첫 4개 및 마지막 4개 레이어는 안정성을 위해 BF16 유지

중간 레이어는 연산량 절감을 위해 FP8 적용

Annealing 단계에서는 전체를 BF16으로 전환

이 방식은 전체 연산량을 약 20% 절감하면서도, 기존에 흔히 발생하던 학습 불안정성 문제를 효과적으로 완화했습니다.

⬥ Pre-training 결과

Table 1. Base 모델의 벤치마크 성능

벤치마크 | k-shot | Tri-21B Base | Qwen3-32B Base |

|---|---|---|---|

MMLU | 5 | 76.99 | 83.61 |

KMMLU | 5 | 62.37 | 53.21 |

KoBEST | 5 | 85.07 | - |

BBH | 25 | 77.19 | 87.38 |

GSM8K | 8 | 70.36 | 93.40 |

MBPPPlus | 3 | 75.40 | 78.80 |

이렇게 사전학습한 Tri-Series 베이스 모델은 다수의 주요 벤치마크에서 우수한 성능을 입증하며, Trillion Labs가 집중해온 사전학습의 효과를 보여주었습니다. 높은 효율성과 적은 자원 투입으로 글로벌 최상위권 오픈소스 모델들과 경쟁 가능한 결과를 만들어낸 점이 특히 의미 있습니다.

Tri-Series를 통해 증명된 XLDA의 가치는 한국어에만 국한되지 않습니다. 전 세계 데이터의 불균형 속에서, XLDA는 영어의 방대한 지식을 다른 언어로 전이시킬 수 있는 가장 효율적이고 범용적인 솔루션입니다.

다음 편에서는 Post-training—SFT, DPO, GRPO 등 실제 서비스 적용을 위한 튜닝 전략과 다양한 벤치마크에 대한 성능까지, Tri-Series를 실용적인 모델로 완성시킨 후반 과정을 소개할 예정입니다.

Tri-Series를 직접 사용해보세요

Tri-Series는 Hugging Face를 통해 전 모델이 공개되어 있습니다. 실험, 연구, 튜닝, 커스터마이징까지 자유롭게 활용하실 수 있습니다.

Read more from our blog

Join our newsletter

Get the latest AI news and insights every week